Nachfolgend mal eine ganz kleine Fallstudie über einer meiner Testseiten (www.modelexikon.com). Diese existiert nun schon seit einigen Jahren und seit einigen Jahren habe ich daran auch nichts mehr gemacht, ja sogar sie nicht mal selbst besucht. So kam es wie es kommen musste, durch eine Umstellung bei meinem Webhoster funktionierte das alte Lexikon-Script nicht mehr, das ich damals mit der Seite getestet habe. Der Google-Bot bekam plötzlich bei allen Seite nur noch einen 500-Fehlercode (Internal Server Error), während die Besucher eine leere Seite zu sehen bekamen. Nachfolgend möchte ich euch den genauen Verlauf aufzeigen und sagen, was ich unternommen habe.

Nachfolgend mal eine ganz kleine Fallstudie über einer meiner Testseiten (www.modelexikon.com). Diese existiert nun schon seit einigen Jahren und seit einigen Jahren habe ich daran auch nichts mehr gemacht, ja sogar sie nicht mal selbst besucht. So kam es wie es kommen musste, durch eine Umstellung bei meinem Webhoster funktionierte das alte Lexikon-Script nicht mehr, das ich damals mit der Seite getestet habe. Der Google-Bot bekam plötzlich bei allen Seite nur noch einen 500-Fehlercode (Internal Server Error), während die Besucher eine leere Seite zu sehen bekamen. Nachfolgend möchte ich euch den genauen Verlauf aufzeigen und sagen, was ich unternommen habe.

Inhalt

Was Google tat

Die Umstellung ereignete sich am 24.09.2014 und damit begannen ab da auch die Probleme. Google machte mich per Webmaster-Tools am erst am 12.10.2014 darauf aufmerksam. Weil ich die E-Mail leider nicht bekam und ich mich erst später in die Webmastertools einloggte, erfuhr ich von dem Problem am 16.10.2014. Das Google das Problem erst so spät bemerkte, liegt wahrscheinlich in der Tatsache begründet, dass der Bot auf der verwaisten Seite nur noch sehr selten vorbei geschaut hat.

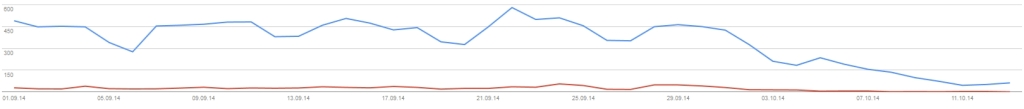

Wie man sieht, hatte die Seite im Durchschnitt etwa 50 Besucher pro Tag über Google. Ab dem 2.10 entschied sich dann die Suchmaschine, sich das Elend nicht weiter anzuschauen und begann damit einzelne Seiten zu deindexieren. Man sieht ab da ganz klar den Abfall der Impression, als auch der Klicks, die schließlich auf nahezu Null gingen. Obwohl alle Unterseiten einen 500-Fehlercode ausgaben, hat sich Google erst einmal auf die Unterseiten zum Deindexieren beschränkt, auf denen auch wirklich Besucher landeten. Andere Unterseiten blieben vorerst verschont, so waren am 16.10.2014 immer noch rund die Hälfte der Seite im Index, Traffic brachten sie aber natürlich nicht.

Was ich tat

Als ich den Fehler bemerkt habe, habe ich natürlich schnell das Script angepasst. Bei so alten Scripts, die auch noch von jemand anderes stammen, dauert das “schnell” ganz schnell mal mehrere Stunden und viele Nerven. Als die Seite dann wieder lief, musste ich nun dafür sorgen, dass der Bot die Seite diesmal etwas früher besuchte. Dafür habe ich in den Webmastertools den Punkt “Abruf wie durch Google” angewähl und die Hauptseite an den Index gesendet, damit Google den Bot vorbei schickt. Anschließend habe ich noch eine aktuelle Sitemap eingereicht, mit der Hoffnung, dass dann wieder bald alle Seiten im Index zu finden sind.

Mehr blieb mir erst einmal nicht übrig und die Zeit musste nun zeigen, wie sich die Seite von dem Problem erholen würde.

Wie gehts nun weiter

Wie schon gesagt, nun entscheidet die Zeit und Google, ob das Projekt wieder auf seine alten Positionen zurückkehrt und wenigstens wieder den Minitraffic,wie vor dem Absturz, erhält. Ich hoffe es kommen keine Updates dazwischen, die das ganze noch verfälschen könnten, denn wie man sieht, hat die Seite einiges an schlechten Inhalten und wurde dafür auch schon zurecht vom Panda abgestraft.

Selbst wenn sich die Seite aber wieder erholt, ist natürlich fraglich, ob das ganze hier repräsentativ ist. Schließlich handelt es sich hier um eine Seite mit kaum Besuchern, die jahrelang brach lag. Dennoch wollte ich das ganze mit euch teilen, vielleicht hat der ein oder andere ja schon das selbe miterlebt und kann ihr mal seine Erfahrungen teilen.

Wie das ganze übrigens ausgeht bzw. ausgegangen ist, das werde ich dann noch einmal in einem separaten Artikel schreiben. Der wird hier natürlich dann verlinkt! Bis dahin, viel Erfolg mit euren Projekten!

Danke für den Einblick! Sehr interessanter Artikel.

Sehr interessanter und hilfreicher Beitrag! Bin gespannt auf dein Update zu diesem Beitrag.

LG Nick

Toller Beitrag und gut geschrieben! Was kam denn schlussendlich dabei raus? 🙂